Tesla plockade i ett uppmärksammat drag bort radarn från sina bilar för en månad sedan. Enligt Elon Musk har den kamerabaserade vision systemet blivit så bra så den hade gjort radarn överflödig.

På Conference on Computer Vision and Pattern Recognition, CCVPR 2021 berättade Andrej Karpathy, Teslas AI chefsarkitekt hur de hade lyckats med att göra bilens kamerabaserade system så bra att varken lidar eller radar längre behövs.

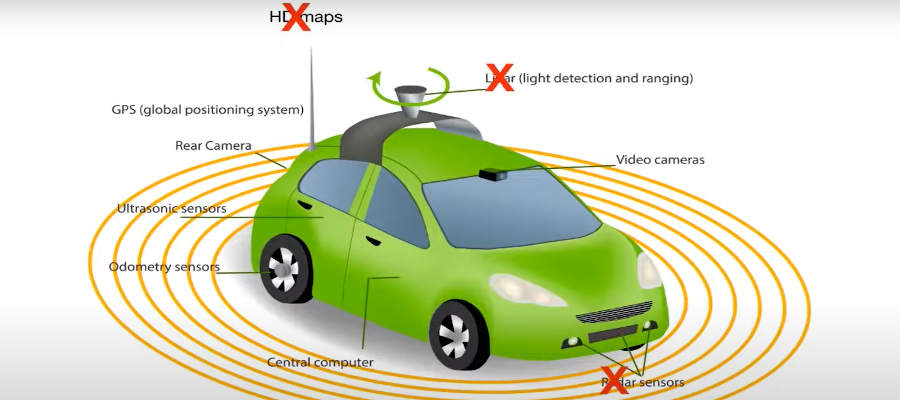

I videon från konferensen berättar han först om att Teslas vägval handlar om mer än enbart kamera vs lidar eller kamera vs radar. Som vi också beskrev i en tidigare artikel handlar det snarare om detaljerade 3D kartor preparerade av människor vs bilen uppfattar gator och vägar och sin omgivning på samma sätt människor gör: genom att titta med sina kameraögon. Istället för att behöva mappa varje gata med millimeternoggrannhet i förväg innan bilarna kan köra där försöker Tesla göra “äkta” självkörande bilar som kan köra även i städer, på gator ingen annan Tesla någonsin hade kört förut.

Sedan berättade Andrej hur ingenjörerna i Tesla insåg att bilarnas kameror även börjat uppfatta omgivningen bättre än bilarnas radar klarade av. När kamerorna blev överlägsna radarn i upplösning och precision behövdes radarns indata allt mindre. De började utveckla AI som kunde effektivt uppskatta de andra bilarnas avstånd, hastighet och acceleration baserat på bilderna bilens kameror levererade.

Artificiell intelligens behöver massor med indata för att lära sig saker. Och en “facit” att jämföra med. Tack vare Teslas enorma flotta med bilar som redan kör runt runt om i världen kunde de snabbt och effektivt samla in datat som behövdes för att träna logiken – och sedan på ett säkert sätt kunna testa den.

Bilarnas dator körde nya AI logiken i så kallat “shadow mode”, där självkörningsdatorn får bilderna från bilens kameror och kan göra sina bedömningar – men som sedan inte påverkar körningen. Även när autopiloten var på kördes bilen av en äldre variant av mjukvaran med radarstöd, den nya var bara med och testades i bakgrunden utan att påverka. Logikens resultat, hur långt borta den trodde bilarna var och snabbt den trodde de åkte kunde sedan enkelt jämföras med facit från radarmätningar mot samma mål. Avvikelser, där kamerabaserade logiken hade fel rapporterades till Teslas centrala servrar för att användas som underlag för förbättringar.

Det krävdes sju vändor med allt bättre algoritmer i “shadow mode” innan ingenjörerna var nöjda med resultatet. Då hade de samlat ihop en miljon små tiosekundersklipp från verkliga körningar som de kunde träna och förbättra sina AI algoritmer med.

![]()

Glädjande för oss i norden handlade en hel del av förbättringarna som Andrej visade exempel på om snö. Till exempel snörök från bilen framför dig. Radarn kunde se igenom den men kamerabaserade vision systemet behövde tränas på att känna igen bilen framför den även om den delvis var dold i snörök.

Efter att de hade släppt nya koden i bilar utan monterad radar kunde de nöjt konstatera att efter 24 miljoner kilometer (varav 3 miljoner med autopilot) hade det fortfarande inte inträffat någon olycka. Med gamla radarsystemet inträffade det i genomsnitt en olycka var 5 miljonte kilometer. Andrej betonade dock att tyvärr kommer det ju inträffa olyckor även med nya systemet förr eller senare – inget system i världen är 100% ofelbart.

Utvecklingen är heller inte helt avslutad. Första versionen av koden ute nu kräver till exempel bra belysning på natten, bilen måste ha sin helljusautomatik på. Som tyvärr är ganska kass, bländar inte av i tid vid möte så många ägare har stängt av den. Tesla måste förbättra antingen vision systemet eller helljusautomatiken innan de nya bilarna blir lika bra på natten som de som haft radar var.

En intressant klipp Andrej visade upp var hur bra bilens mjukvara blivit på att uppfatta djup i bilderna. Från videobilden till vänster kunde bilens mjukvara bygga upp 3D representationen av det bilen såg till höger – som påminner kusligt mycket om resultat från lidar sensorer! Det är därför Tesla inte behöver några dyra lidar sensorer utan klarar sig med enkla kameror: datorn kan tolka bilderna och få fram samma information i alla fall. (Faktiskt ännu mer: kolla på vita linjerna på gatan på bilden ovan. De syns även i 3D representationen av bilens omgivningar – men en lidar sensor skulle inte uppfattat de linjerna.)

Istället för förinskannade detaljerade 3D kartor som tusentals mänskliga operatörer måste förbereda innan bilen kan köra på en gata använder Teslas AI bilens kameror på ungefär samma sätt du använder dina ögon, för att i realtid, på plats i bilen känna igen var gatan är, var du kan köra.

Andrej nämnde i förbifarten den komplexa självkörningsdatorn som sitter i Teslas bilar och som simulerar miljoner av hjärnceller. Det är inte traditionell “mjukvara” som körs i de datorerna utan neuroner i komplexa nätverk som tolkar det kamerorna ser.

Men för att ta fram hur det neurala nätverket i bilarna ska se ut behöver de mycket mer kraftfulla datorer:

Teslas egen superdator (en av tre, faktiskt) har 720 noder med sammanlagt 5760 GPU processorer med 80 GB minne var. Den är kapabel till otroliga 1.8 miljoner Teraflops beräkningar, vilket gör den till den femte kraftfullaste superdatorn i världen.

Den kör heller inte traditionell mjukvara utan simulerar neuroner, “hjärnceller”. Genom att matas med förinspelade videoklipp har den ett trick datorerna i bilarna inte klarar: den kan köra videoklippet framåt och bakåt och på så sätt “resa i tiden”: gör den ett felaktigt beslut kan den köra filmklippet den matats med baklänges igen och se exakt var den behöver förbättra sig. Och försöka om och om igen, tills den har bemästrat situationen. Sedan nästa videoklipp med en annan scenario. Superdatorn som är tusentals gånger kraftfullare än de i bilarna kan tränas med indata från hundratusentals olika bilar som råkar ut för olika trafiksituationer runt om i världen. När superdatorn har kört igenom alla miljoner fall med trafik den tränats med får man fram ett neuralt nätverk som reagerar rätt i alla de situationerna och den kan sedan komprimeras till ett “fastlåst”, enklare nätverk som inte kan lära sig mer på egen hand men som får plats i bilarnas datorer. Det neurala nätverket i bilarna kan inte lära sig nya saker på egen hand – men den har den samlade erfarenheter av hundratusentals bilar.

Andrej avslutade sin presentation med att betona att Tesla är det enda företaget som utvecklar alla delarna av självkörande system själva: bilarna, som samlar in miljoner med indata, som tränar superdatorer Tesla själva hade byggt, som tar fram helt egna neurala nätverk utan tredjepartsdelar, som sedan körs i datorer Tesla själva utvecklat utrustade med chip Tesla själva utvecklat i Teslas egna bilar. Inget annat företag i världen sitter med alla korten i hand. Ofta koncentrerar sig företag på små delmängder av problemet och är beroende av inköpta komponenter och tjänster från andra. Kom jobba hos oss – var Andrejs själva poäng med hela presentationen. Tesla är på jakt efter talanger i alla yrkesområden, från AI konstruktörer till de som sköter om superdatorerna.

Vill du titta på Andrejs hela presentation kan du göra det här:

Tibor, rad två…

“blivit så bra så den hade gjort kameran överflödig”…

lol sömnbrist

Tas det upp något om problemet med att upptäcka hinder framför t.ex. släpet i bildexemplet du använde dig av? Det är något som kamera inte kan upptäcka, medan en LiDAR skulle göra det? Kameran skulle bara upptäcka det om bilen med släpet faktiskt agerar (men då antar vi att den bilen upptäcker det i tid). Är detta något som tagits upp?

Om du menar att radarn kan se flera bilar framåt tog jag upp det redan i förra artikeln om borttagningen av radarn: https://teslaclubsweden.se/sa-fungerar-sjalvkorande-bilar/

I Norge er det mange lange tunneller, hvor det fra tid til annen oppstår bilbrann. Det forårsaker mye røyk som gjør at man ikke vil kunne se veien. Vil en Tesla på autopilot finne veien videre ut av tunnellen gjennom tett, ugjennomsiktig røyk? Det vil trolig stå andre biler i tunnellen, og være hindringer.

Väldigt välskriven artikel och sammanfattning. Fantastiskt bra kvalitetsarbete av Tibor, och mycket intressant att läsa om.

Jag ser självkörande elbilar om ett nytt listigt drag av det klimatindustriella komplexet. Köpa nya dyrare bilar, helst skrota fullt fungerande bilar. Vilket smart drag av bilbranschen.

Min önskan är att primärt minska antalet körda bilmil – halvera dem och ökade kollektiva/tåg och buss.med en faktor 4. Men bilbranschen vill naturligtvis ha fler bilar,